OpenAI ha pasado en dos años de ser un laboratorio con pérdidas y dudas de gobernanza a convertirse en el epicentro de la mayor carrera tecnológica de la década. En paralelo, su director ejecutivo, Sam Altman, ha planteado una visión ambiciosa: construir infraestructura de chips, centros de datos y energía a una escala sin precedentes para acelerar la inteligencia artificial (IA) y, con ella, “un futuro de abundancia”. El reto no es menor: esa apuesta exige inversiones de cientos de miles de millones de dólares y un suministro energético gigantesco, mientras la compañía sigue ajustando su modelo de gobierno y de financiación.

En 2024, OpenAI comunicó a sus empleados que su facturación anualizada rondaba los 3.400 millones de dólares, cifra que marcó un salto respecto a 2023 pero que queda lejos del volumen de compromisos de gasto que distintos ejecutivos y socios han insinuado para la próxima década. Varios análisis y anuncios corporativos apuntan a que el esfuerzo inversor agregado podría alcanzar entre 500.000 millones y 1,4 billones de dólares en infraestructura de cómputo, nubes públicas y chips especializados hasta 2030, un rango amplio que refleja tanto la incertidumbre como la magnitud del plan.

El debate ya no es si la IA seguirá creciendo, sino a qué coste y con qué contrapesos. En los últimos meses OpenAI firmó acuerdos para ampliar su capacidad de cómputo fuera de su socio histórico —Microsoft—, como el pacto para usar Oracle Cloud Infrastructure o el contrato multianual con Amazon Web Services (AWS). La empresa también corrigió públicamente la idea de que busque garantías explícitas del Estado para sus préstamos tras unas declaraciones de su directora financiera que generaron polémica. Todo ello dibuja una estrategia: sumar proveedores, blindar acceso a chips y capital, y aclarar —en lo posible— de dónde saldrá el dinero.

Este artículo contrasta datos y antecedentes clave —ingresos, compromisos de gasto, energía, datos y gobernanza— con información pública verificable. No evalúa la calidad técnica de los modelos ni pronostica la velocidad de la IA, sino que examina la coherencia entre las promesas y los números que las sustentan.

La escala ya no es un eslogan: la estrategia de OpenAI se mide en gigavatios, gigafábricas y acuerdos de nubes por decenas de miles de millones. La cuestión es quién paga, con qué reglas y a cambio de qué.

Cifras, contratos y el coste real de escalar la IA

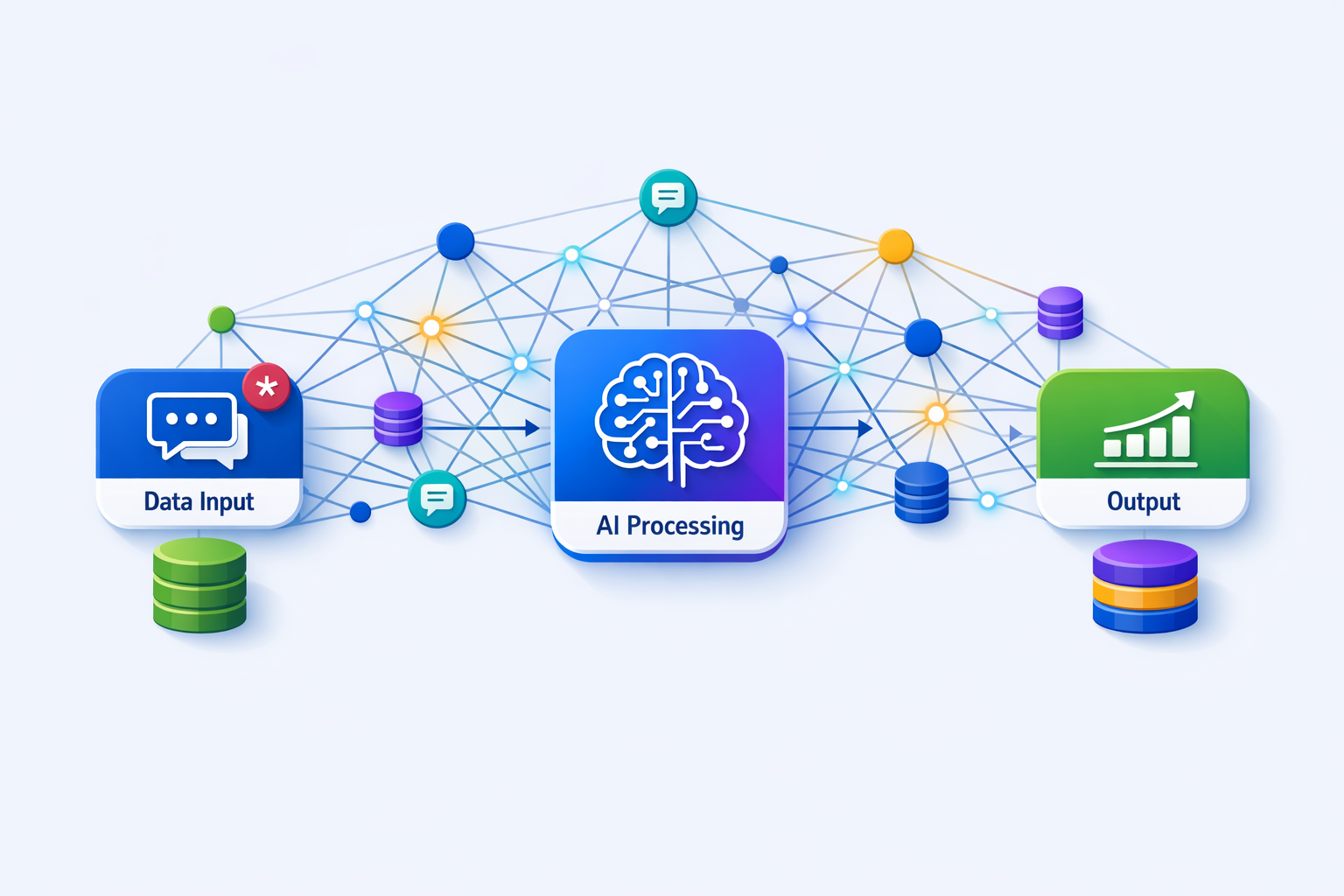

La primera pieza son los ingresos. En junio de 2024, OpenAI comunicó a su plantilla que su facturación anualizada alcanzaba 3.400 millones de dólares, con la práctica totalidad procedente de suscripciones y licencias de modelos, y una pequeña parte atribuida a la venta de acceso a través de Azure. Es una base relevante, pero modesta frente a las necesidades de capital y energía que implican los planes de expansión.

La segunda pieza son los contratos de infraestructura. En 2024 OpenAI acordó extender la plataforma de Microsoft Azure usando recursos de Oracle Cloud Infrastructure (OCI), un movimiento que diversificó proveedores y reforzó su acceso a GPU de última generación. Un año después, a finales de 2025, la compañía anunció un acuerdo de siete años por 38.000 millones de dólares con AWS para capacidad de cómputo dedicada, con despliegue total previsto antes de 2027. Ambos pasos subrayan un patrón: asegurar computación a gran escala con varios socios, sin romper el enlace estratégico con Microsoft.

La tercera pieza son las expectativas. Análisis recientes estiman que el gasto acumulado de OpenAI hasta 2030 podría acercarse a 500.000 millones de dólares, cifra que otras informaciones elevan —con reservas— a 1,4 billones en la próxima década si se agregan centros de datos, chips y energía. Aunque los importes varían por fuente y metodología, el mensaje es coherente: el cómputo de frontera exige inversiones muy superiores a la facturación actual del sector.

En paralelo, una controversia comunicativa encendió la discusión pública en noviembre de 2025: la directora financiera de OpenAI habló en un foro sobre “ecosistemas” de financiación que podrían incluir garantías gubernamentales (“backstops”) para abaratar el coste de la deuda en grandes proyectos de chips. La reacción llevó a una rectificación inmediata: OpenAI afirmó que no busca un aval del Estado y que su objetivo es la colaboración público‑privada para reforzar la capacidad industrial, no subsidios que socialicen riesgos. La precisión importa porque define el tipo de política industrial que se discute para la cadena de valor de la IA.

La financiación es el primer filtro de realidad: si la apuesta por la IA de frontera se apoya en deuda masiva, el precio del capital y la capacidad de ejecución de los proveedores de nubes y chips serán tan determinantes como el avance científico.

Trayectoria y patrón de gestión: de Loopt a Y Combinator

Para entender la aversión de Altman a quedarse corto de recursos conviene mirar atrás. Su primera empresa, Loopt, nació en 2005 como una app de geolocalización social. En 2012 la compró Green Dot por 43,4 millones de dólares y fue descontinuada poco después. Días antes de la venta, un reportaje reveló que Loopt habría caído a apenas 500 usuarios activos diarios; Altman negó el dato y prometió publicar cifras, algo que no sucedió. El episodio fue leído como un choque entre narrativa y tracción real. Años más tarde, inversores de Green Dot cuestionaron la lógica de aquella adquisición y alertaron de posibles conflictos de interés por el papel de un mismo fondo en ambas compañías.

Tras Loopt, Altman fundó el fondo Hydrazine Capital y, ya en 2014, asumió la presidencia de Y Combinator (YC). Un perfil del New Yorker documentó que el 75% del capital de Hydrazine se invirtió en compañías de YC, un dato relevante para entender su alcance en el ecosistema y el debate sobre los límites entre aceleradora e inversión propia. Ese mismo texto anticipó otra constante: orientar capital y atención hacia “hard tech” (energía, chips, biotecnología) más allá del software puro.

Desde entonces, el itinerario se bifurcó en dos líneas paralelas. Por un lado, la creación de OpenAI en 2015 y su posterior evolución; por otro, inversiones personales en compañías energéticas y de hardware que hoy encajan con las necesidades de la propia OpenAI. La coherencia estratégica —IA de alto rendimiento y energía abundante— es evidente; el desafío es gestionar las fronteras entre intereses y gobernanza.

Gobernanza y misión: de la fundación original al modelo PBC

OpenAI nació como organización sin fines de lucro con una carta fundacional explícita: “evitar usos de la IA que dañen a la humanidad o concentren indebidamente el poder” y un compromiso de que su “deber fiduciario primario es con la humanidad”. Esas frases siguen vigentes en la OpenAI Charter y constituyen la vara con la que se evalúa cualquier giro corporativo.

En 2019, para escalar investigación y despliegue, la estructura incorporó una filial “con beneficio limitado” (capped‑profit) controlada por la entidad sin ánimo de lucro. En 2025 la organización anunció una evolución adicional: la filial pasaría a ser una Public Benefit Corporation (PBC) —sociedad de beneficio e interés común—, manteniendo el control por parte de la fundación. La lógica declarada: acceder a capital y flexibilidad sin renunciar al mandato público. El detalle jurídico importa: una PBC debe considerar el interés de las partes afectadas, pero no subordina por ley el beneficio a la misión, por lo que la credibilidad del modelo depende de su gobierno efectivo y de su capacidad de transparencia.

En paralelo, OpenAI ha diversificado proveedores de nube sin romper con Microsoft, su socio estratégico y accionista. En 2024 oficializó con Oracle la extensión de Azure en OCI para ganar capacidad de entrenamiento; en 2025, tras reordenar su gobernanza, comunicó su acuerdo de varios años con AWS para cómputo dedicado. Estos pasos sugieren que el “deber fiduciario hacia la humanidad” de la carta convive con la necesidad práctica de asegurar cómputo en varias nubes a gran escala, bajo criterios de coste, rapidez y resiliencia de la cadena de suministro.

La misión en mármol se prueba en acero: una carta que proclama un deber fiduciario con la humanidad exige una gobernanza capaz de resistir las tensiones entre capital, velocidad y concentración de poder.

Energía y hardware: del sueño de la fusión al “puente” de gas y fisión

La expansión de la IA no es sólo una cuestión de chips; es, ante todo, una cuestión de energía. En 2023 Helion —empresa de fusión nuclear en cuyo consejo Altman ejerce de presidente y donde dijo invertir 375 millones de dólares— firmó con Microsoft el primer contrato de compra de electricidad de fusión con objetivo de entrega en 2028 (al menos 50 MW). Helion sostiene que está en trayectoria para lograrlo; el sector científico, con razón, mantiene escepticismo prudente sobre plazos. Sea cual sea el desenlace, el acuerdo fijó un listón de ambición sobre cómo financiar energía “cero carbono” para centros de datos. Anuncio de Helion–Microsoft.

La fisión, por su parte, es el plan de continuidad. Oklo, compañía de reactores rápidos de pequeño tamaño, salió a bolsa en 2024 tras fusionarse con la SPAC AltC (de la que Altman fue consejero delegado). En 2025, Oklo y Liberty Energy anunciaron una alianza “integral” para grandes cargas: potencia inicial con generación a gas y gestión de demanda, y, a medida que lleguen los reactores, suministro base limpio con sus “powerhouses” Aurora. Es, en la práctica, un puente: cubrir la demanda inmediata con gas mientras la nuclear avanza licencias, fabricación y despliegue.

El vector energético tiene además un número de referencia que se ha instalado en el debate: 250 gigavatios de capacidad de cómputo‑energía para 2033. Algunos medios han vinculado esa cifra a objetivos de OpenAI/Altman y la han equiparado al consumo eléctrico de países enteros; otros la tratan como un escenario de industria. Más allá de la precisión, el orden de magnitud ilustra el dilema: cada ola de modelos más capaces implicará más electricidad —y, en consecuencia, decisiones sobre tecnologías, agua de refrigeración y redes— que no pueden dejarse a la entropía.

Datos e identidad: de Reddit a World

La IA de propósito general se alimenta de datos. En mayo de 2024, OpenAI firmó con Reddit un acuerdo de licencia para usar sus contenidos en entrenamiento y para integrar publicaciones en ChatGPT. El pacto se produjo cuando Altman ya no estaba en el consejo de Reddit (salió en 2022), aunque conserva una participación accionarial significativa desde hace años. El movimiento consolidó una tendencia: acuerdos de datos con grandes repositorios comunitarios, tras varias disputas sobre “web scraping” y propiedad intelectual.

El historial entre Altman y Reddit tiene otro capítulo que conviene recordar: en 2014, tras una ronda liderada por inversores de YC, la empresa anunció que “devolvería” un 10% del valor a su comunidad mediante un instrumento llamado “Reddit Notes”, una idea que nunca se materializó por razones regulatorias y técnicas. Aquella promesa frustrada es una lección sobre lo difícil que es convertir en hechos una narrativa de “beneficios ampliamente distribuidos”.

La identidad digital es la otra cara del dato. Altman cofundó World (antes Worldcoin) junto con Alex Blania y Max Novendstern para verificar “prueba de humanidad” mediante el escaneo de iris con el “Orb” y emitir una credencial (World ID) y un token. El proyecto se relanzó en 2024 con foco en verificación y, en 2025, abrió locales en varias ciudades de EE. UU., mientras negocia con reguladores donde sus operaciones fueron suspendidas, como en España o Kenia, por dudas de privacidad y tratamiento de datos biométricos. La cuestión es si la verificación biométrica masiva —y su incentivo económico— es un antídoto proporcionado contra los bots en la era de la IA. World sostiene que sí; varias autoridades piden cautela. World (Worldcoin).

¿Qué revela el patrón? Lecciones, límites y preguntas abiertas

Primera lección: la escala manda. La hoja de ruta de OpenAI combina acuerdos de cómputo con varios hiperescalares, inversión (propia y de terceros) en energía y una estructura jurídica diseñada para atraer capital sin renunciar —en el papel— a una misión pública. En ese marco, la promesa de Altman en foros y entrevistas —que él no busca enriquecerse vía equity en OpenAI— ha sido constante desde 2023, aunque la compañía ha ajustado su estructura corporativa y su consejo. Son mensajes que buscan blindar legitimidad ante el tamaño de la factura.

Segunda lección: la trayectoria cuenta. El caso Loopt recordó los costes de una narrativa sin base de usuarios; Hydrazine y YC mostraron la capacidad de Altman para dirigir capital hacia apuestas de “hard tech”; Helion y Oklo explican por qué la energía es ahora una prioridad de primer orden para la IA. Nada de eso prueba por sí solo que la estrategia actual sea infalible, pero sí que responde a una visión cohesionada: acelerar la IA requiere controlar (o al menos asegurar) chips, nubes y electrones.

Tercera lección: la misión exige gobernanza verificable. La OpenAI Charter habla de un “deber fiduciario primario con la humanidad” y de evitar concentraciones indebidas de poder. Que eso sea algo más que una consigna dependerá de la transparencia en los contratos de datos, de los límites a los conflictos de interés y de la calidad de la supervisión independiente en la nueva estructura PBC bajo control de la fundación.

Cuarta lección: el Estado no es un cheque en blanco. La polémica del “backstop” dejó claro que, aun en proyectos estratégicos, la línea entre política industrial y aval público es sensible. Las rectificaciones de la dirección financiera de OpenAI y de su consejero delegado acotaron el alcance: colaboración público‑privada sí; garantías explícitas, no. Ese matiz define el tipo de relación con los contribuyentes que la industria busca en esta fase.

La promesa de “abundancia” no es una ley de la física: depende de ejecuciones impecables, mercados de capitales pacientes, redes eléctricas fiables y marcos regulatorios que mantengan a raya la concentración y protejan la privacidad.

Conclusión

El “trato” que Altman propone —inversión masiva hoy a cambio de un mañana de energía barata, ciencia acelerada y productividad ubicua— no se decide con un eslogan, sino con números, contratos y normas. Los datos verificados permiten despejar algunos excesos retóricos: los ingresos de OpenAI crecen con fuerza pero están a años luz de sus compromisos potenciales; la diversificación hacia OCI y AWS es real; los acuerdos energéticos —de la fusión aspiracional a la fisión “puente” apoyada en gas— buscan cubrir un déficit que no se resuelve sólo con software; y la identidad “prueba de humano” abre tanto oportunidades como dilemas de privacidad.

Aun así, quedan preguntas sustantivas: ¿serán sostenibles financieramente los compromisos si sube el coste del capital o se ralentiza el crecimiento del negocio? ¿Podrá el sistema eléctrico absorber, con bajo impacto ambiental, la nueva demanda de centros de datos? ¿Habrá límites efectivos a la concentración de datos y de poder de mercado? Y la más importante: ¿cómo se medirá el cumplimiento del “deber fiduciario con la humanidad” cuando la misión colisione con plazos y retornos?

Las promesas de la IA merecen ser tomadas en serio, pero también auditadas con rigor. Las cifras, los contratos y la energía —no los eslóganes— serán los que resuelvan si el futuro que se ofrece es una abundancia compartida o una concentración sin precedentes.