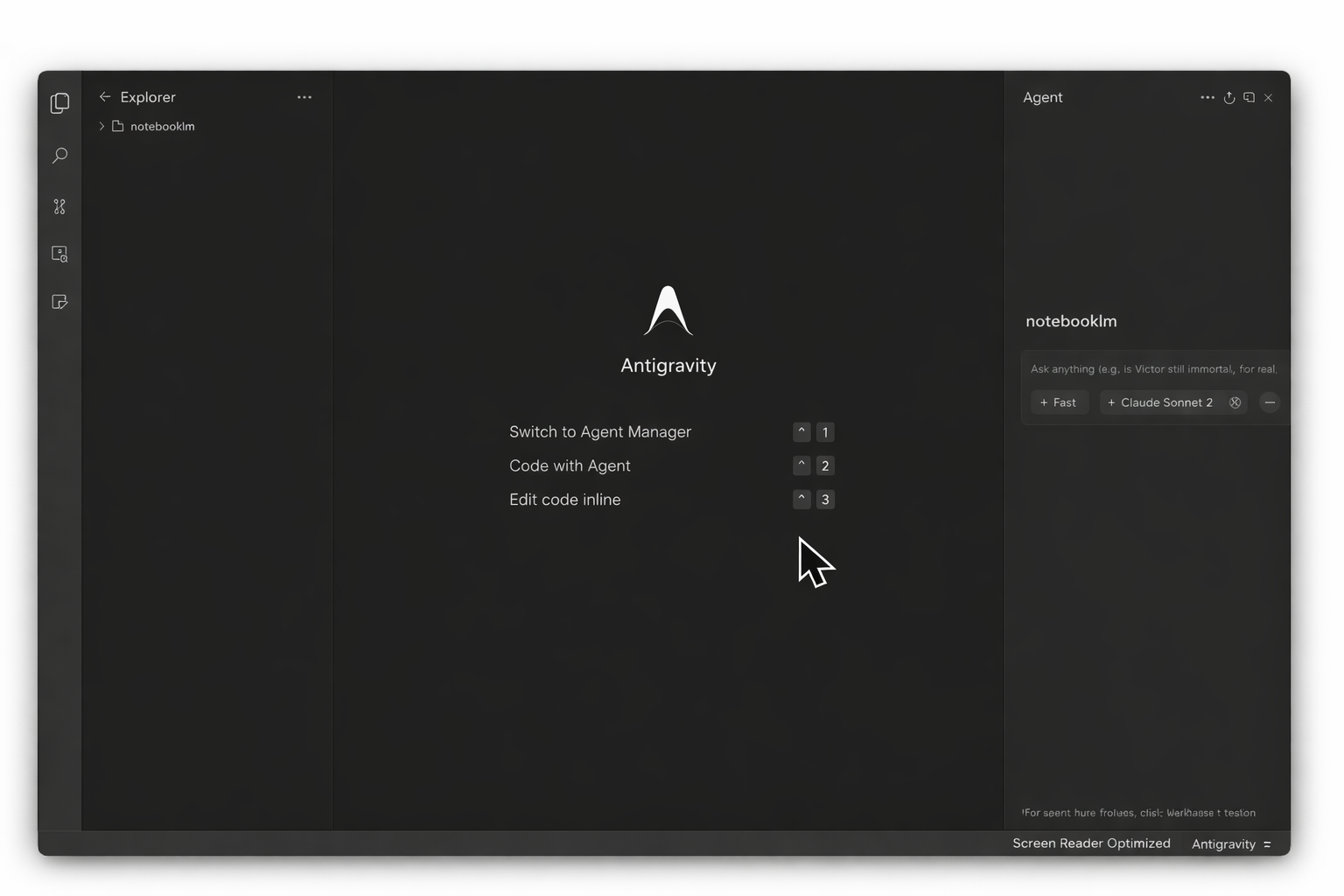

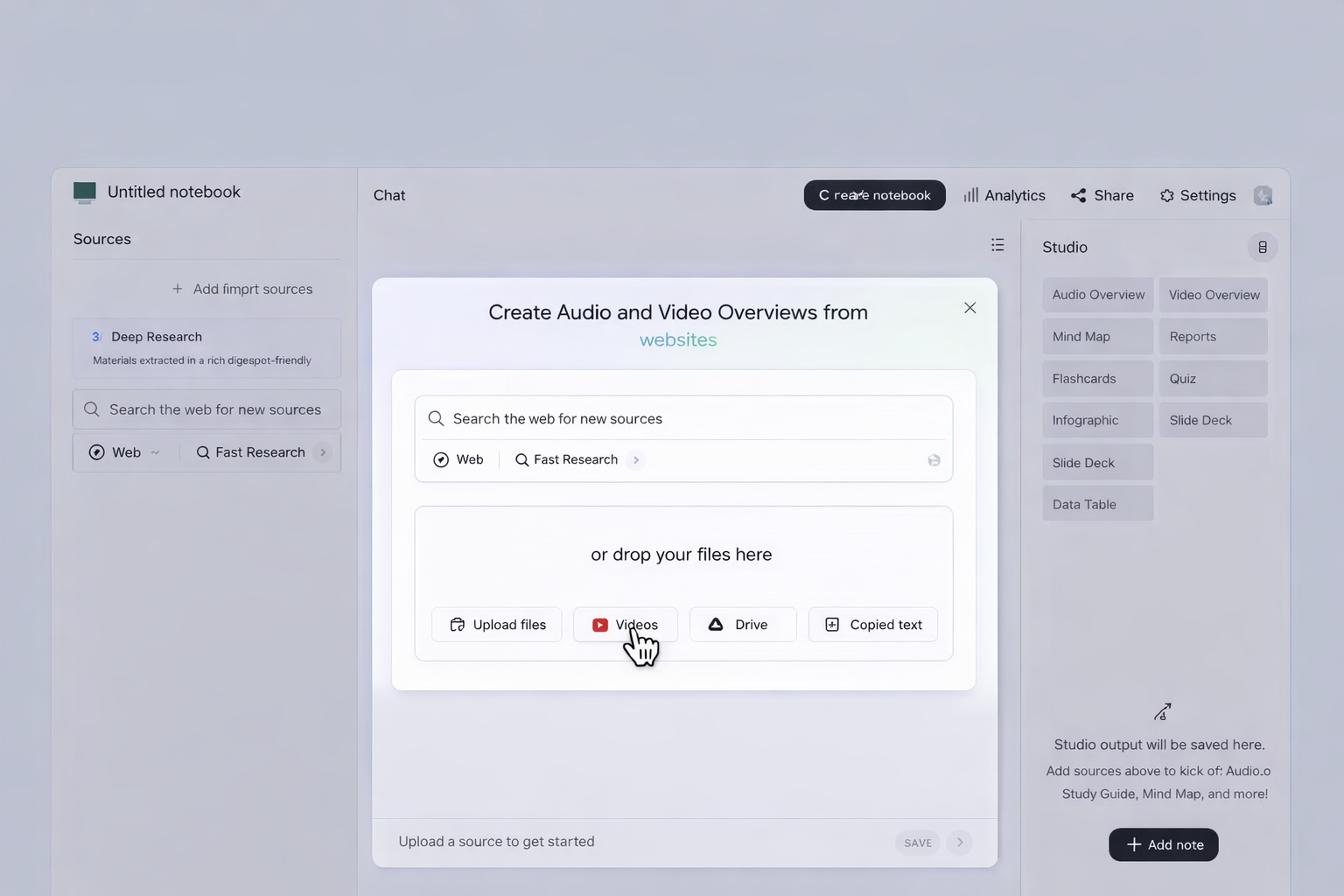

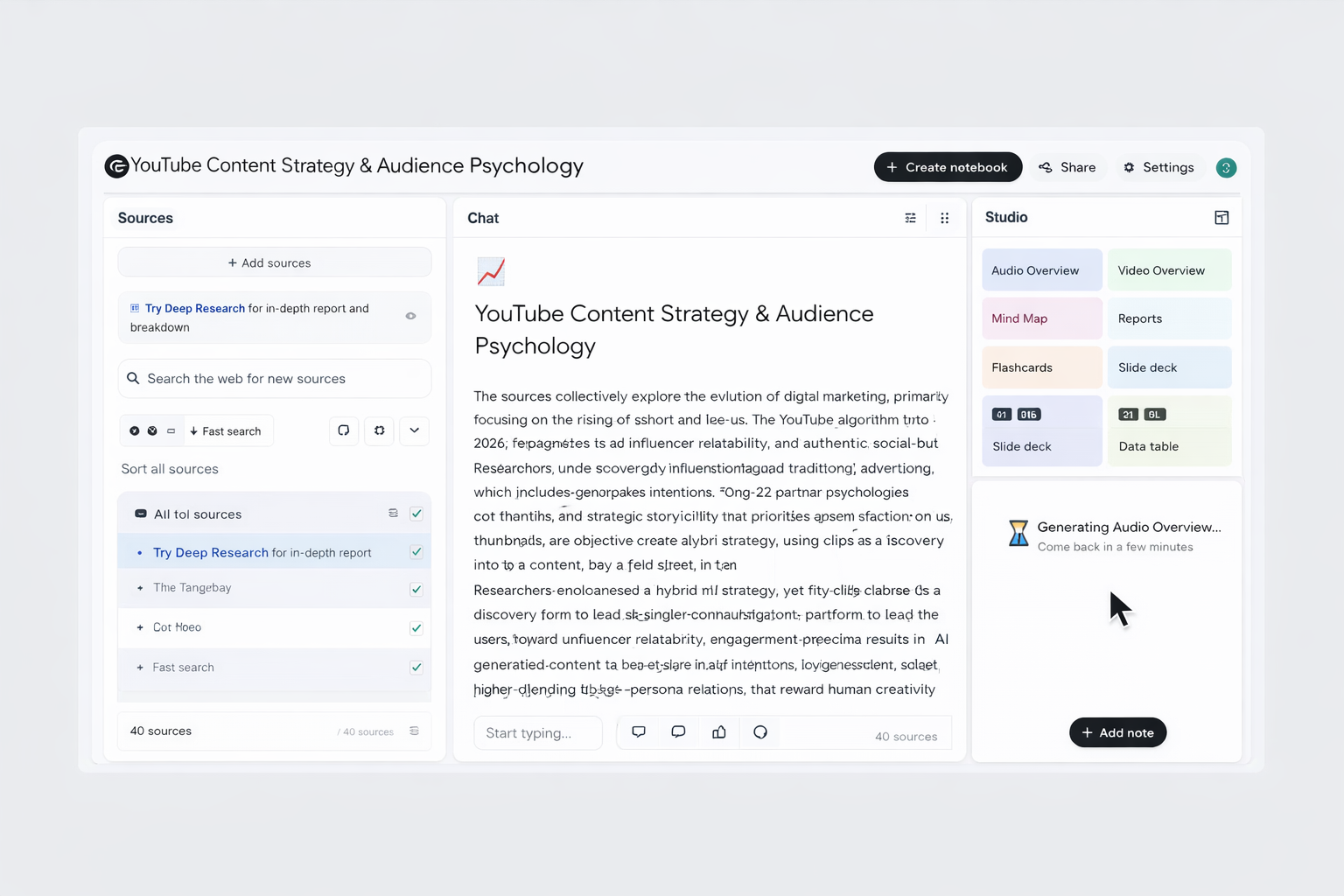

En los últimos meses han ocurrido dos cambios relevantes que conviene tener presentes desde el principio. Primero, Antigravity salió a la luz como un entorno “agent‑first” con dos vistas (Editor y Manager), “Artifacts” verificables y soporte no solo para Gemini, sino también para otros modelos de terceros. Con esto, orquestamos varios agentes en paralelo y revisamos sus entregables como listas de tareas, planes o capturas. Segundo, NotebookLM incorporó la función de Deep Research, que ofrece un modo rápido y otro profundo, presenta un plan antes de investigar y devuelve resultados con citas. Además, el panel Studio añadió salidas como Audio/Video Overviews, Mind Maps, Reports y formatos de estudio como Flashcards y Quizzes. Estas capacidades son clave para trabajar a escala sin sacrificar la comprobación de fuentes.

También es importante precisar el motor. NotebookLM actualizó su modelo de QA y razonamiento durante 2025, con mejoras de la familia Gemini 2.5 en chat y contexto. Esto se tradujo en respuestas más consistentes para cuadernos extensos y contenidos técnicos, y sentó las bases para sus funciones móviles y de Studio. Es un dato práctico que nos conviene conocer para dimensionar expectativas al conectarlo con agentes en Antigravity.

Separar el conocimiento de la ejecución nos permite investigar una sola vez, y reutilizar esa inteligencia en múltiples tareas de código, contenidos o validación, con menos latencia y más control de calidad.

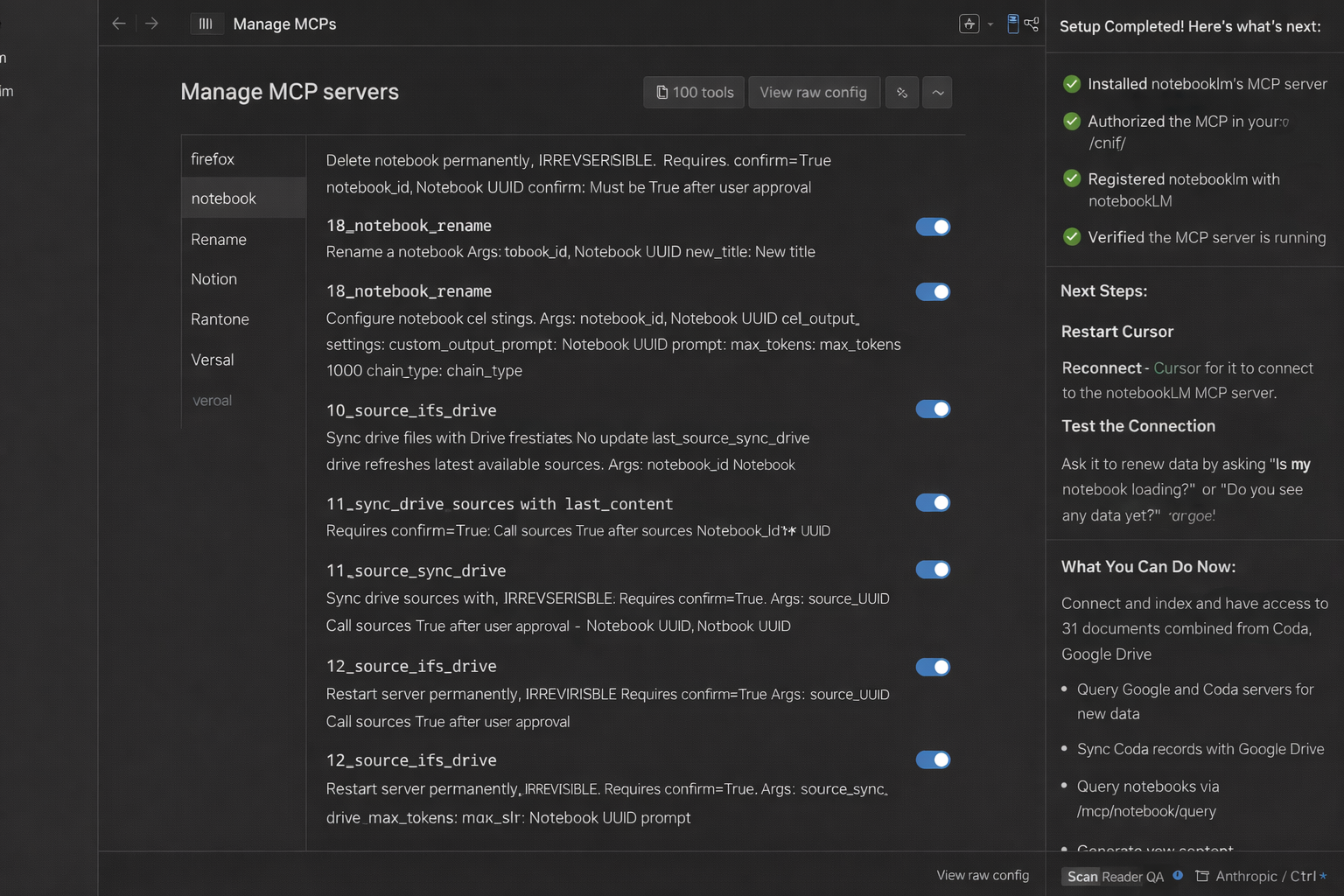

La integración que exploraremos no requiere copiar textos entre ventanas. Aprovecharemos un servidor MCP comunitario para que nuestros agentes consulten NotebookLM directamente, con autenticación persistente y gestión de cuadernos desde la propia consola del agente. La investigación se hace una vez, con fuentes citadas, y luego la reutilizamos en el flujo de desarrollo.

Qué aporta cada pieza y qué cambió en 2025–2026

Entendemos Antigravity como un IDE con enfoque de agentes. En la vista Editor trabajamos como en un IDE clásico con un agente lateral, mientras la vista Manager actúa como “torre de control” para coordinar múltiples agentes a la vez. La idea central es que los agentes tengan acceso directo al editor, el terminal y el navegador, y documenten su trabajo en “Artifacts” que cualquiera puede verificar. Esta filosofía no solo acelera, también reduce discusiones sobre “qué hizo el agente y por qué”, porque las evidencias quedan adjuntas al proceso.

Por su parte, NotebookLM dejó de ser solo “un lector inteligente” y pasó a funcionar como un estudio de producción de conocimiento. Con Deep Research podemos elegir entre un modo rápido o uno profundo, ver un plan antes de ejecutar la investigación y continuar añadiendo fuentes mientras la tarea corre en segundo plano. El panel Studio permite generar salidas listas para compartir: Audio Overviews, Video Overviews, Mind Maps y Reports. Además, añadió formatos didácticos como Flashcards y Quizzes, con control de dificultad y número de preguntas, pensados para estudiar o entrenar equipos con la misma base documental.

Otra mejora práctica es la expansión de entradas y servicios: NotebookLM admite más tipos de archivos, enlaces y datos de Workspace, y su experiencia móvil incorporó funciones clave como historial de chat. Son ajustes que notaremos cuando conectemos los cuadernos con agentes y necesitemos continuidad entre escritorio y teléfono.

Cómo se conectan y qué ganamos

Cuando un agente en Antigravity necesita contexto, solemos darle acceso a archivos locales. Ese camino tiene dos costes: cada lectura consume tokens y tiempo, y el agente rehace trabajo si cambian pocos párrafos. Conectar NotebookLM como “memoria externa” resuelve ambos problemas. El cuaderno concentra fuentes y análisis, y el agente consulta respuestas ya sintetizadas, con citas y sin releer carpetas enteras. El resultado es menos latencia y mejor trazabilidad.

La conexión se realiza mediante Model Context Protocol (MCP), el estándar abierto impulsado por Anthropic que unifica cómo los modelos acceden a herramientas y datos. MCP funciona como un “puerto universal” que permite a clientes compatibles, incluido Antigravity, añadir servidores que exponen recursos y acciones de forma estandarizada. En nuestro caso, usamos un servidor MCP para NotebookLM que automatiza autenticación por navegador y ofrece utilidades para listar cuadernos, seleccionar el activo, lanzar Deep Research y leer respuestas con citas.

En la práctica, vemos dos efectos inmediatos:

- Reducimos relecturas repetitivas del agente, porque delegamos la comprensión de documentos al cuaderno.

- Ganamos outputs reutilizables. Si Studio generó un Audio Overview, un Mind Map o un Report, los agentes pueden apoyarse en esas piezas para codificar, escribir guías o validar decisiones con menos ambigüedad.

El patrón de trabajo cambia de “indexa y relee” a “investiga, cita y reutiliza”, con el IDE consultando un conocimiento estable y siempre auditado.

Instalación

A continuación, configuramos un servidor MCP comunitario para que nuestros agentes accedan a NotebookLM desde Antigravity. Usamos el proyecto PleasePrompto, autor del repositorio “notebooklm-mcp”. Al ser software de terceros, conviene probarlo primero en un entorno de desarrollo y con una cuenta de Google dedicada al laboratorio.

Preparar el entorno de trabajo

Necesitamos Node.js LTS actualizado y Google Chrome instalado. Verificamos versiones y conectividad.

node -v

npm -v

Añadir el servidor MCP de NotebookLM en el cliente de agentes compatible

En clientes con CLI (por ejemplo, Claude Code o entornos compatibles con MCP), agregamos el servidor siguiendo la instrucción estándar del repositorio “notebooklm-mcp”.

Para configuraciones basadas en archivo, podemos declarar el servidor en el JSON de MCP del cliente:

{

"mcpServers": {

"notebooklm": {

"command": "npx",

"args": [

"-y",

"notebooklm-mcp@latest"

]

}

}

}

Autenticar NotebookLM con el navegador

Le pedimos al agente que inicie sesión en NotebookLM. Se abrirá una ventana de Chrome. Completamos el login con la cuenta de pruebas y confirmamos que el servidor guarda la sesión.

Crear o reutilizar un cuaderno

En NotebookLM creamos un cuaderno y añadimos fuentes. Podemos combinar PDFs, Docs, sitios, GitHub y, cuando proceda, lanzar Deep Research para consolidar fuentes con un plan claro y citas. Verificamos que el servidor MCP lista el cuaderno y puede seleccionarlo como contexto activo.

Si preferimos anclar la autoría y el repositorio del servidor MCP, el proyecto “notebooklm-mcp” es de PleasePrompto y está disponible en GitHub como notebooklm-mcp. Desde allí encontraremos variantes de instalación para otros clientes MCP y comandos útiles de diagnóstico.

Cinco niveles de uso, con ejemplos directos

Pasemos de la configuración a la práctica. Estos cinco niveles resumen un camino de menor a mayor sofisticación apoyándonos en cuadernos verificados y agentes coordinados.

Nivel 1. Crear cuadernos de forma programática

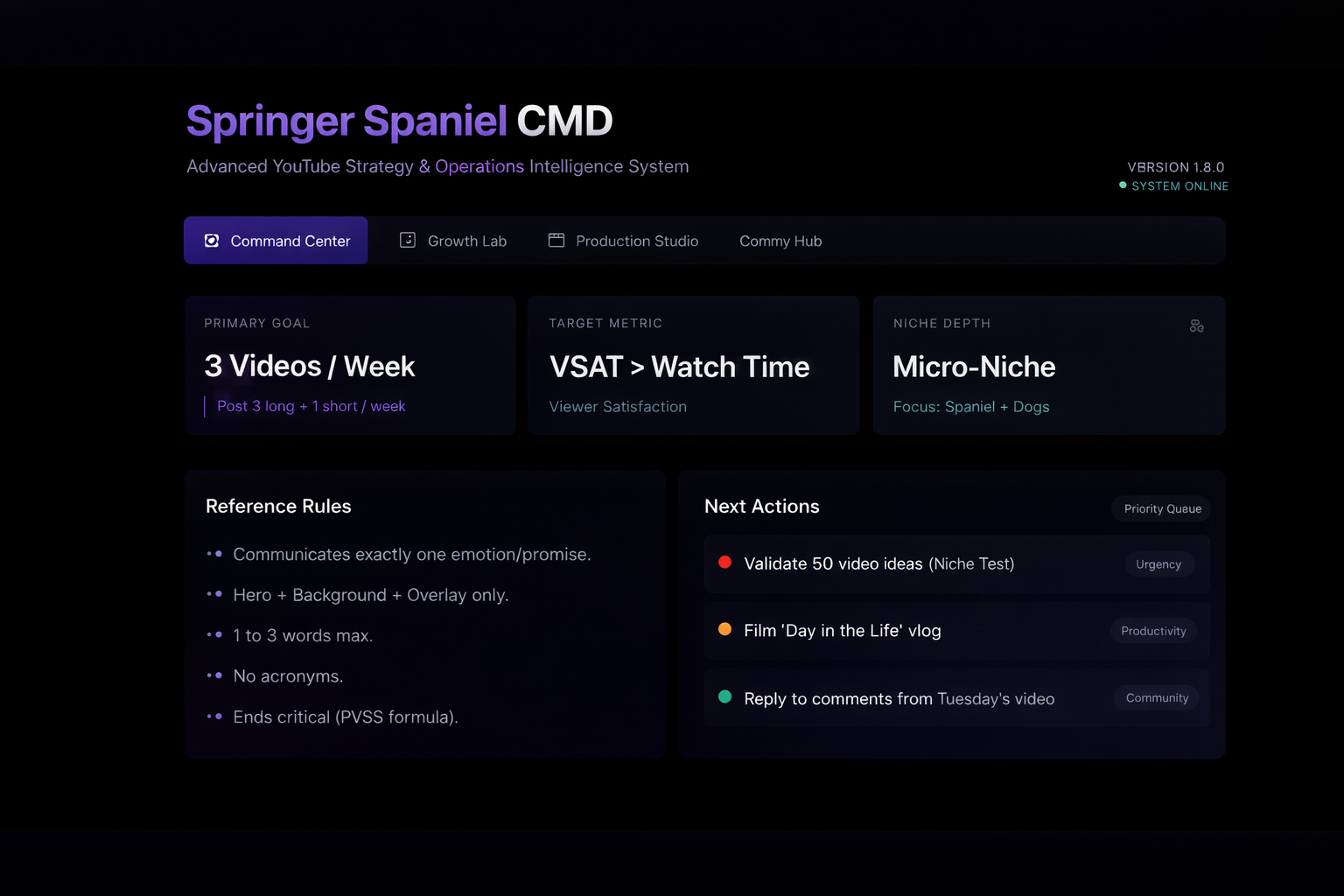

Podemos pedir al agente que proponga un temario específico y que, a continuación, cree los cuadernos base en NotebookLM y dispare Deep Research donde tenga sentido. Ejemplo concreto: estamos planificando una nueva línea editorial sobre “crecimiento de un canal de YouTube canino”. Solicitamos cinco áreas críticas, estrategia, empaquetado de títulos y thumbnails, retención y narrativa, algoritmo y SEO, y analítica, y pedimos crear cinco notebooks con Deep Research activado. Al terminar, tendremos una base con fuentes citadas para cada frente.

Nivel 2. Conversar con varios cuadernos desde un único chat de Antigravity

En Manager, asignamos un agente para mantener una “guía de cerebro” del proyecto, y otro para responder a preguntas con el cuaderno más pertinente en cada caso. Si preguntamos “cómo programar tres videos semanales sobre una raza específica”, el agente consulta cuadernos de estrategia, empaquetado y retención, y nos devuelve un plan accionable con citas y un calendario tentativo. Repetimos la operación para refinar hooks o probar hipótesis de título, siempre con contexto consistente.

Nivel 3. Construir productos con conocimiento embebido

Antigravity permite que los agentes abran el navegador, ejecuten comandos y generen interfaces. Podemos pedir “un dashboard de estrategia de videos” con métricas, checklist y un módulo que recomiende mejoras según los benchmarks reunidos en NotebookLM. El agente consulta los cuadernos, extrae fórmulas clave, por ejemplo, metas de CTR o señales de retención, y plasma un panel en una one‑pager HTML funcional. El valor diferencial no es el HTML, es que el contenido refleje un conocimiento ya validado y con fuentes.

Nivel 4. Producir contenidos de Studio a escala

Desde el propio flujo de agentes lanzamos outputs de Studio en los cuadernos: Audio Overviews para briefings, Video Overviews para explicar procesos, Mind Maps para alinear equipos y Reports para documentación viva. Si el equipo necesita practicar, generamos Flashcards o Quizzes acotados al cuaderno activo, con dificultad y número de preguntas configurables. Todo queda vinculado a las mismas fuentes, lo que simplifica auditorías y correcciones.

Nivel 5. Ingerir lotes locales, incluidos PDFs, y convertirlos si hace falta

Si tenemos actas, SOPs o presentaciones en el portátil, subimos los paquetes a NotebookLM. Cuando haya PDFs complejos, el agente puede preparar un script para convertirlos a texto antes de importarlos. El objetivo es el mismo: consolidar la base en el cuaderno para que el resto del trabajo sea consulta con citas, no scraping local reiterado.

Riesgos, límites y recomendaciones

Entender el alcance real de Antigravity. Aunque la orquestación multi‑agente y el control del navegador aceleran mucho, también exigen gobernanza: políticas de permisos, entornos de prueba y una lista de comandos peligrosos que requieran confirmación manual. Recordemos que hay reportes públicos sobre fallos y riesgos cuando damos carta blanca a la ejecución automática. Por eso recomendamos operar con cuentas de prueba y proyectos sandbox antes de tocar activos críticos.

Respetar la autoría y el carácter comunitario del servidor MCP. El conector que usamos para NotebookLM es de terceros. Conviene revisar su changelog, comprender la autenticación por navegador y, si trabajamos con datos sensibles, aislar perfiles de Chrome. Si el agente no necesita ver un recurso, no lo expongamos.

Validar las respuestas con citas. NotebookLM devuelve respuestas sustentadas y, si no encuentra la información en las fuentes, lo indica. Ese comportamiento reduce al mínimo la alucinación, pero no reemplaza la revisión de un responsable de dominio. Incorporar la lectura de la cita como parte del definition of done es una buena práctica que amortiza errores.

Planificar la carga de Deep Research. El modo profundo ejecuta una estrategia más exhaustiva y devuelve informes con rutas de lectura. Es ideal para temas nuevos o fronteras de conocimiento. Para dudas puntuales, el modo rápido es suficiente. Alternar ambos nos da un balance entre cobertura y tiempos.

Cuidar la experiencia móvil y la continuidad. NotebookLM ya ofrece historial de chat y mejores sesiones en iOS y Android, algo útil para repasar fuera del escritorio. Aun así, la producción de materiales complejos sigue siendo más cómoda en el navegador de escritorio, donde Studio brilla por su flexibilidad.

Conclusiones

Al unir NotebookLM con Antigravity mediante MCP, convertimos el ciclo de “investigar, decidir y construir” en una secuencia continua y comprobable. Centralizamos el conocimiento en cuadernos con citas, automatizamos la consulta desde agentes que trabajan en el editor, y reutilizamos salidas de Studio como audio, video, mapas, reportes y formatos de estudio. Ganamos velocidad, sí, pero sobre todo ganamos claridad: cada decisión se ancla a una fuente y cada ejecución deja rastro en “Artifacts”.

No se trata de sustituir a los equipos, sino de liberar su tiempo de la repetición. Cuando un agente puede recuperar el dato exacto desde un cuaderno y enlazar la cita, nosotros podemos enfocarnos en el diseño del producto, la arquitectura o la edición que importa. Ese es el impacto real: menos fricción entre lo que sabemos y lo que hacemos, con evidencias al alcance de un clic.

En la práctica, el camino empieza por configurar un servidor MCP, crear un primer cuaderno, y activar Deep Research solo donde aporte. Desde ahí, escalamos con múltiples notebooks y agentes coordinados. Si mantenemos el rigor en las fuentes y una gobernanza prudente en Antigravity, estaremos más cerca de un desarrollo con conocimiento vivo, auditable y reutilizable.

En ese viaje, vale la pena recordar tres hábitos: investigar una vez y citar siempre, reutilizar outputs de Studio antes de reescribir, y revisar los “Artifacts” como parte de la entrega. Con esos pilares, la dupla NotebookLM‑Antigravity deja de ser una promesa y se convierte en una práctica diaria.